AI– tag –

-

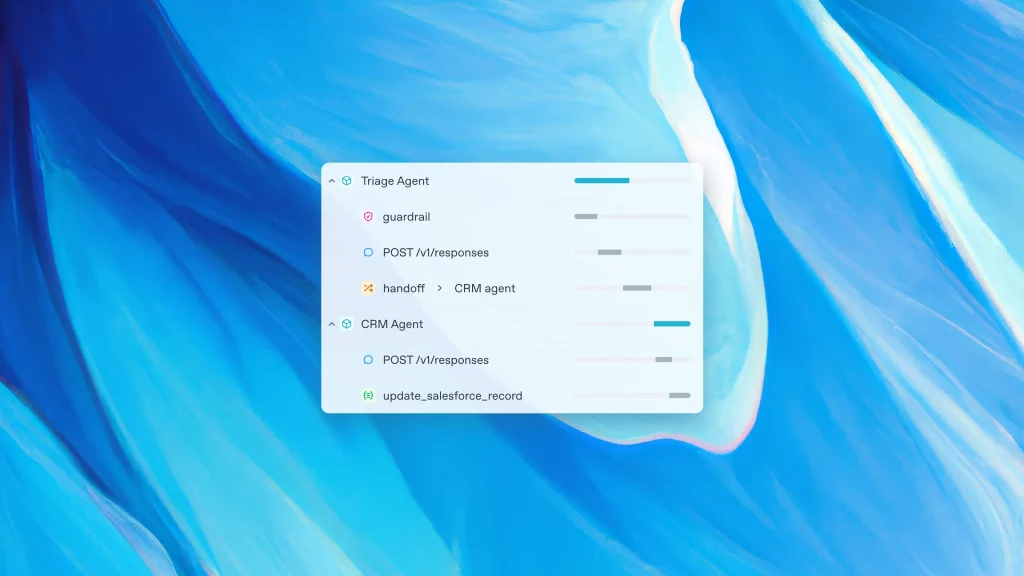

OpenAI Agent SDKでアプリを構築する

まえがき OpenAIから開発者向けにAgent SDKが発表されたました。これを機にpythonとReactでゼロからアプリ構築をしていきたいと思います。今回は、シンプルなチャットアプリを構築していきます。 ファイル作成 フロントエンドファイルの作成 ルートディレ... -

BrowserUseを実行するためのセットアップ方法

以下では、Gemini API (google-generativeai, langchain-google-genai) と browser-use を組み合わせて活用するための手順や実行方法をご紹介します。仮想環境の作成からサンプルコードの実行例までを網羅した内容になっていますので、ぜひ参考にしてくだ... -

APIウェブアプリケーションの作り方

概要 今回、ウェブアプリケーションを作成する上で使用するAPIはGoogleが提供するGemini 1.5 Proです。 Gemini 1.5 Pro は次世代の大規模言語モデル(LLM)で、優れた自然言語生成能力を持っています。この記事では、Gemini 1.5 Pro APIを利用したシンプル... -

ChatGPTのO1 proを活用して目標設定を行う手順

目標を達成するためには、具体的な計画と正しい手順が必要です。しかし、「何から始めたらいいかわからない」と迷う方も多いのではないでしょうか?そこで今回は、ChatGPTのO1 proを活用して、自己分析からキャリアプランの設計、目標設定までを効率的に行... -

AIツールを活用して簡単にウェブサイトを構築する方法

近年加速するAIツール AI技術は近年、驚くべきスピードで進化しています。特にOpenAIがGPT-4をリリースした2023年以降、多くのAIツールが登場し、さまざまな分野で活用されるようになりました。その中でも、Webサイトの構築に特化したAIツールは大きな注目... -

Difyの基本ブロックを使ったワークフロー構築

Difyのワークフローとは? Difyで一連の処理を自動化してアプリケーションを作成できる機能のことを指します。 Difyのワークフローを構築するにはノード(ブロックやツール)をマップ上に配置し、各ノードを線で繋いでいくことで構築することができます。 ... -

【LLAMA3の特徴】LLAMA3は何が凄いのか

圧倒的な大規模モデル LLAMA3は、80億パラメータと700億パラメータの2つのモデルで構成されています。このスケールメリットにより、幅広い分野での高い汎用性能が期待できます。膨大なパラメータ数により、LLAMA3はより複雑な情報を処理し、より人間らしい...

1