AI– category –

-

Chainlit製チャットアプリを本番運用へ ― Herokuデプロイとユーザー管理を整備した記録

はじめに 個人開発で育てている Chainlit 製チャットアプリ「AgentApp」を、ポートフォリオとして外部公開できるレベルまで仕上げるために作業したログをまとめます。今回は ユーザー登録〜認証/DB永続化/Herokuデプロイ/CI設定 までを一気に... -

AIチャットアプリのOSSを公開します

AIのAPIを初めて触ってから約10ヶ月。。仕事の合間に作業を進めていました、ついにAIチャットアプリケーションのOSSを公開することができました。 1ヶ月ほど前に一度公開した後、細かい修正を行い、git hubのソースコードを更新していました。 もう少しき... -

Claude Code SDK ~自己改善アプリケーションの構築~

※本記事の内容は実際のコーディング結果をもとにClaude Opus4で生成した記事です。 はじめに 2025年6月、AnthropicがリリースしたClaude Code SDKは、AIを活用した革新的なコーディング支援ツールです。本記事では、Claude Code SDKを使って「アプリケーシ... -

MineCraftでAIとコンピュータを作成する

まえがき 私はかつてMineCraftで想像的な遊びを行うのはなかなか難しいと考えていました。 YouTubeでAIのbotを使用している人やレッドストーンコンピュータを作成している人の動画を見て興奮したのを覚えています。 これこそが自分にとって興味を湧き立て... -

Claude4の登場(2025/05/23)

Claude4シリーズ Anthoropic社の発表により、Claude4シリーズの発表がありました。前回から約3ヶ月ぶりの新モデル発表となりました。 AIのモデルの進化スピードは加速してきているので、早速キャッチアップしていきたいと思います。 発表動画のまとめ 今回... -

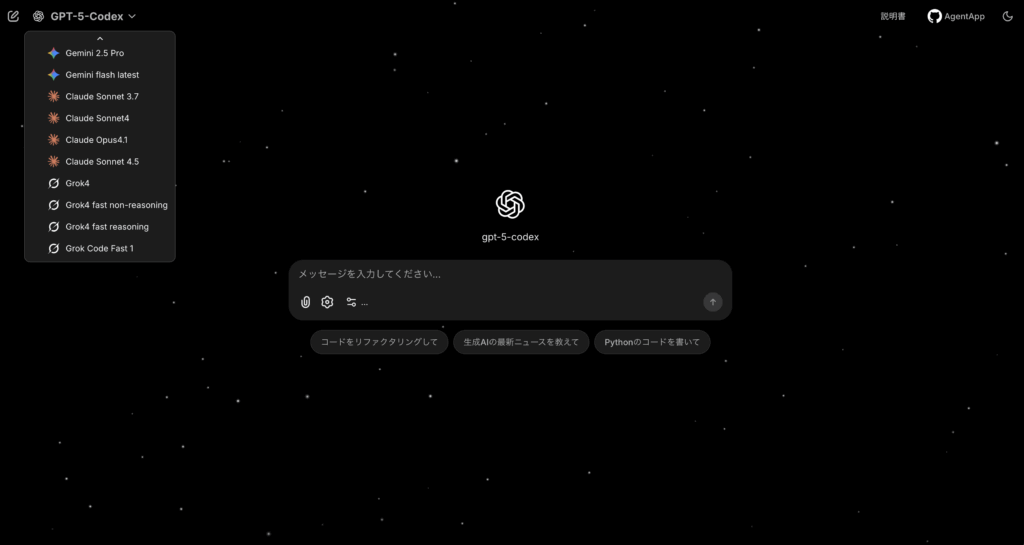

IT LIFE -AI Agent-

イントロダクション 2025年からAIの技術に興味を持ち、APIを使ったアプリケーションを作成したいと考えていました。ChatGPTやGeminiなどの複数のアプリケーションを使用していましたが、1つの場所で複数のモデルを使用したいと思うようになりました。そこ... -

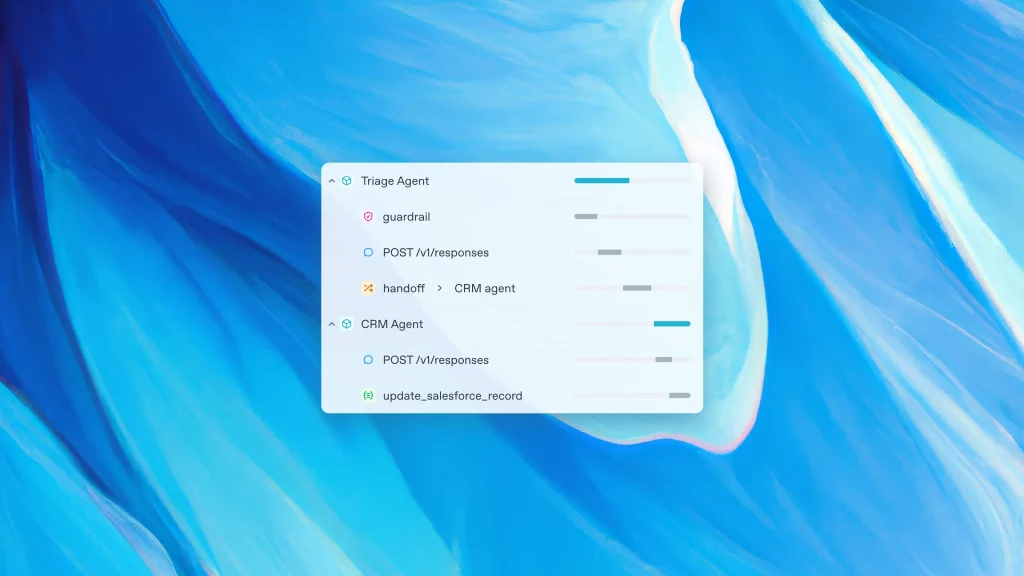

OpenAI Agent SDKでアプリを構築する

まえがき OpenAIから開発者向けにAgent SDKが発表されたました。これを機にpythonとReactでゼロからアプリ構築をしていきたいと思います。今回は、シンプルなチャットアプリを構築していきます。 ファイル作成 フロントエンドファイルの作成 ルートディレ... -

BrowserUseを実行するためのセットアップ方法

以下では、Gemini API (google-generativeai, langchain-google-genai) と browser-use を組み合わせて活用するための手順や実行方法をご紹介します。仮想環境の作成からサンプルコードの実行例までを網羅した内容になっていますので、ぜひ参考にしてくだ... -

APIウェブアプリケーションの作り方

概要 今回、ウェブアプリケーションを作成する上で使用するAPIはGoogleが提供するGemini 1.5 Proです。 Gemini 1.5 Pro は次世代の大規模言語モデル(LLM)で、優れた自然言語生成能力を持っています。この記事では、Gemini 1.5 Pro APIを利用したシンプル... -

ChatGPTのO1 proを活用して目標設定を行う手順

目標を達成するためには、具体的な計画と正しい手順が必要です。しかし、「何から始めたらいいかわからない」と迷う方も多いのではないでしょうか?そこで今回は、ChatGPTのO1 proを活用して、自己分析からキャリアプランの設計、目標設定までを効率的に行...

12